Ontdek hoe je gegevens slim indeelt op structuur, herkomst en doel-van gestructureerd tot ongestructureerd, en van first-party tot open data-zodat je sneller de juiste opslag, tools en analyses kiest. Je leest hoe metadata, AVG-regels, pseudonimisering en anonimisering in de praktijk werken en wanneer je kiest voor batch, realtime of streaming. Met praktische tips voor datakwaliteit, beveiliging en kosten vertaal je data naar inzichten en resultaten die écht verschil maken.

Wat zijn soorten gegevens

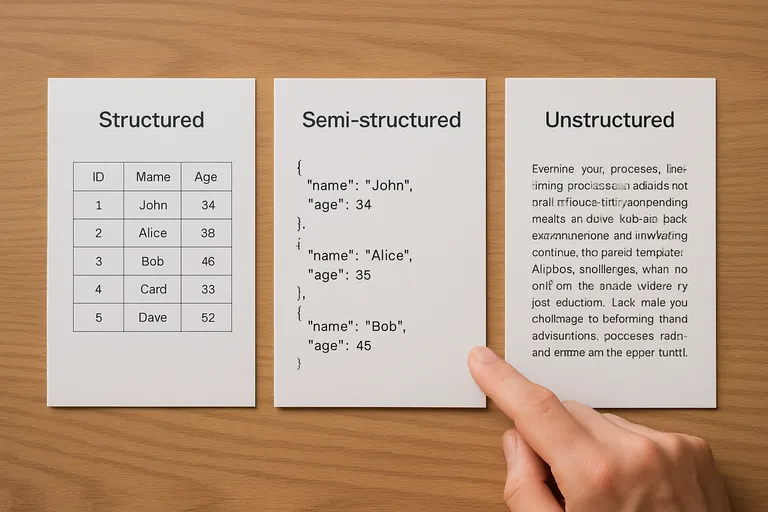

Soorten gegevens beschrijven de verschillende manieren waarop informatie is vormgegeven, opgeslagen en gebruikt. In de basis kijk je naar de structuur: gestructureerde gegevens zitten in vaste kolommen en rijen, zoals een spreadsheet of een SQL-database, waardoor je ze makkelijk kunt doorzoeken en koppelen. Semi-gestructureerde gegevens hebben een flexibel schema, zoals JSON (een tekstformaat met naam-waardeparen) of XML, waardoor je velden kunt toevoegen zonder het hele model om te gooien. Ongestructureerde gegevens hebben geen vast model, denk aan vrije tekst, e-mails, afbeeldingen, audio en video; krachtige zoek- en AI-tools helpen je hier betekenis uit te halen. Daarnaast speelt herkomst en gevoeligheid een rol: persoonsgegevens vragen om extra zorg en beveiliging, terwijl geanonimiseerde of geaggregeerde data minder herleidbaar zijn naar individuen.

Je kunt ook kijken naar datadoel en gebruik: transactionele data registreren gebeurtenissen zoals bestellingen, analytische data sturen analyses en dashboards, kwantitatieve data zijn meetbaar in cijfers en kwalitatieve data vatten meningen of beschrijvingen samen. Metadata – gegevens over je gegevens, zoals bron, tijdstip en formaat – maken alles vindbaar, interpreteerbaar en betrouwbaar. Door je data zo te indelen, kies je sneller de juiste opslag, integratie en analysetools, minimaliseer je risico’s rond privacy en compliance, en haal je meer waarde uit wat je al verzamelt.

Waarom het indelen naar type je helpt

Door gegevens eerst in duidelijke types te verdelen, maak je datawerk concreet en beheersbaar. Het geeft richting aan hoe je verzamelt, bewaart en analyseert.

- Sneller de juiste keuzes: je ziet direct welke tools, opslag en analysemethoden passen per type; je voorkomt misfits doordat gestructureerde data om andere queries en modellen vraagt dan ongestructureerde bestanden.

- Hogere kwaliteit en beheersbaarheid: gericht valideren, standaarden toepassen en duplicaten opsporen; lifecycle management voor retentie en archivering; kosten sturen met hete versus koude opslag.

- Betere compliance en samenwerking: onderscheid tussen persoons-, pseudonieme, anonieme en geaggregeerde data maakt gerichte beveiliging en rechtenbeheer mogelijk en helpt voldoen aan de AVG; teams gebruiken dezelfde taal.

Zo werk je efficiënter én veiliger, met minder verrassingen achteraf. Het resultaat: snellere projecten en betere beslissingen.

Basisbegrippen: data, metadata en datamodellen

Data zijn de ruwe feiten die je verzamelt, zoals getallen, teksten, datums, beelden of metingen. Op zichzelf zeggen ze weinig zonder context. Metadata geven die context: het zijn gegevens over je gegevens, zoals de bron, het tijdstip van vastlegging, het formaat, definities van velden, kwaliteitsscores en wie eigenaar is. Dankzij metadata kun je data terugvinden, juist interpreteren en vertrouwen. Datamodellen beschrijven hoe je data logisch zijn gestructureerd en aan elkaar relateren.

Ze leggen entiteiten, attributen, relaties en regels vast, bijvoorbeeld in een relationeel schema, een documentstructuur of een graafmodel. Een goed datamodel maakt je data consistent, herbruikbaar en performant, ondersteunt validatie en governance en helpt je kiezen tussen schema-on-write (strak vooraf) of schema-on-read (flexibel bij analyse).

[TIP] Tip: Classificeer gegevens: publiek, intern, vertrouwelijk, strikt vertrouwelijk.

Indeling op basis van structuur

Onderstaande vergelijking laat in één oogopslag zien hoe soorten gegevens op basis van structuur verschillen in schema, formaten en manier van opslaan en bevragen – handig om snel de juiste aanpak en tooling te kiezen.

| Soort gegevens | Structuur & schema | Voorbeelden / formaten | Opslag & bevraging |

|---|---|---|---|

| Gestructureerd | Vast schema (kolommen, datatypes), sterke referentiële integriteit; schema-on-write. | Tabellen; SQL-databases; CSV/TSV; spreadsheets. | Relationele databases en datawarehouses; query met SQL (joins, aggregaties, constraints). |

| Semi-gestructureerd | Flexibel/zelfbeschrijvend; variabele velden; schema-on-read mogelijk. | JSON, XML, YAML; log events; key-value records. | Documentstores en data lakes; bevraging met JSONPath/XPath of SQL-on-JSON (bijv. VARIANT/STRUCT-velden). |

| Ongestructureerd | Geen vooraf gedefinieerd schema; betekenis uit inhoud/metadata. | Tekst/PDF, beeld (JPEG/PNG), audio (MP3/WAV), video (MP4), e-mail. | Bestands- of objectopslag; zoeken via full-text search, NLP/OCR, spraak-naar-tekst, embeddings. |

Kernpunten: hoe strikter de structuur, hoe beter traditionele SQL en datakwaliteitscontroles werken; hoe minder structuur, hoe belangrijker metadata, preprocessing en gespecialiseerde zoek/ML-methoden.

Bij de indeling op basis van structuur kijk je naar hoe strikt je gegevens zijn georganiseerd en welk schema je gebruikt. Gestructureerde gegevens volgen een vast model met kolommen en rijen, zoals in een SQL-database of een CSV-bestand, waardoor je met duidelijke definities snel kunt filteren, joinen en rapporteren. Semi-gestructureerde gegevens hebben een flexibel schema: formaten als JSON en XML bevatten tags of sleutel-waardeparen, zodat je nieuwe velden kunt toevoegen zonder het hele model te breken; je gebruikt dan vaak schema’s als JSON Schema en querytools die nested data aankunnen.

Ongestructureerde gegevens hebben geen vooraf gedefinieerde structuur, denk aan tekst, afbeeldingen, audio en video; die maak je doorzoekbaar met indexing, vector search en NLP of computer vision. De gekozen structuur bepaalt waar je data het best opslaat (relationele database, documentstore, data lake), hoe je valideert (schema-on-write of schema-on-read), en welke performance je mag verwachten. Door dit onderscheid bewust te maken, kies je gerichter tooling, beperk je fouten en haal je sneller bruikbare inzichten uit je data.

Gestructureerde gegevens (tabellen, SQL, CSV)

Gestructureerde gegevens volgen een vooraf gedefinieerd schema met kolommen en rijen. Tabellen in relationele databases (via SQL) en vlakke bestanden als CSV passen hierbij. Je definieert datatypes, primaire sleutels, referentiële relaties en validatieregels, waardoor de kwaliteit hoog en queries voorspelbaar zijn. Dankzij indexen en joins kun je snel filteren, groeperen en combineren, ideaal voor rapportages, dashboards en transactionele toepassingen.

CSV werkt goed voor uitwisseling en eenvoudige pipelines, terwijl een SQL-database betere waarborgen biedt voor integriteit (constraints, transacties) en security. Je kunt data normaliseren voor consistentie of denormaliseren voor snelheid, afhankelijk van je gebruik. Door schema-on-write leg je structuur vast bij het laden, wat onderhoud vereenvoudigt, kosten beperkt en samenwerking tussen teams versimpelt.

Semi-gestructureerde gegevens (JSON, XML)

Semi-gestructureerde gegevens combineren een duidelijke hiërarchie met een flexibel schema. In JSON werk je met sleutel-waardeparen en geneste objecten, in XML met tags en attributen; beide beschrijven zichzelf, waardoor je velden kunt toevoegen zonder bestaande data te breken. Dit maakt ze ideaal voor API’s, eventstreams en configuraties. Je queryt ze met JSONPath of varianten van SQL die nested data ondersteunen, en in XML met XPath of XQuery.

Validatie kan met JSON Schema of XML Schema (XSD), zodat je formats en regels afdwingt. Je slaat zulke data vaak op in documentdatabases of een data lake, waar schema-on-read handig is. Let op indexering, versiebeheer en contracten tussen systemen, anders ontstaan performanceproblemen en onduidelijkheid over betekenis en datakwaliteit.

Ongestructureerde gegevens (tekst, beeld, audio, video)

Ongestructureerde gegevens hebben geen vaste kolommen of rijen en variëren van e-mails en PDF’s tot foto’s, geluidsopnames en videobestanden. Omdat een helder schema ontbreekt, haal je betekenis uit de inhoud zelf met technieken als NLP (taalverwerking) voor tekst, OCR (teksterkenning) voor scans, ASR (spraak-naar-tekst) voor audio en computer vision voor beelden en video. Door tags, beschrijvingen en metadata toe te voegen maak je dit materiaal vindbaar en bruikbaar in zoekfuncties en analyses.

Embeddings (vectorvoorstellingen) en vector search helpen je semantisch te zoeken op inhoud, niet alleen op trefwoorden. Je slaat zulke data vaak op in object storage en beheert versies, rechten en retentie via duidelijke policies. Let op privacy, want bestanden kunnen persoonsgegevens bevatten die je moet afschermen of anonimiseren volgens de AVG.

[TIP] Tip: Classificeer gegevens bij binnenkomst: gestructureerd, semi-gestructureerd, ongestructureerd; kies opslag passend.

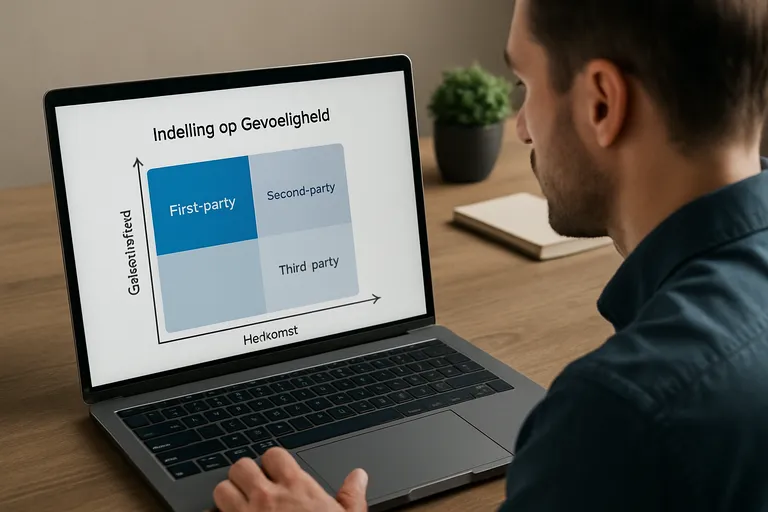

Indeling op basis van herkomst en gevoeligheid

Bij indeling op basis van herkomst kijk je naar waar je data vandaan komen en hoeveel controle je erover hebt. First-party data verzamel je zelf via je website, app of kassa en zijn het meest betrouwbaar. Third-party data koop je of haal je via platforms van anderen en vragen extra controle op kwaliteit en rechten. Open data zijn vrij beschikbaar en handig voor verrijking, maar je checkt altijd bron, licentie en actualiteit. Gevoeligheid gaat over privacy en risico’s. Persoonsgegevens kunnen iemand direct of indirect identificeren en vallen onder de AVG; bijzondere persoonsgegevens, zoals gezondheid of geloof, vragen extra bescherming.

Je kunt data pseudonimiseren door directe identifiers te vervangen door codes, of anonimiseren zodat herleiden niet meer mogelijk is; geaggregeerde data bundel je tot groepsniveaus om risico’s te verlagen. Door data te classificeren in niveaus als publiek, intern, vertrouwelijk of strikt vertrouwelijk bepaal je toegang, encryptie, bewaartermijnen en opslaglocatie. Zo borg je compliance, beperk je schade bij incidenten en werk je efficiënter met duidelijke spelregels.

Persoonsgegevens en bijzondere persoonsgegevens (AVG)

Persoonsgegevens zijn alle gegevens die je direct of indirect naar een persoon kunnen herleiden, zoals naam, e-mailadres, IP-adres of een cookie-ID. Bijzondere persoonsgegevens zijn extra gevoelig, zoals gegevens over gezondheid, ras of etnische afkomst, politieke opvattingen, religie, vakbondslidmaatschap, genetische of biometrische data en iemands seksueel leven of geaardheid. Onder de AVG mag je deze categorie in principe niet verwerken, behalve als een specifieke uitzondering geldt en je extra waarborgen treft.

Voor elke verwerking heb je een geldige grondslag nodig, denk aan toestemming, uitvoering van een overeenkomst, wettelijke plicht of gerechtvaardigd belang. Je past principes toe als dataminimalisatie, doelbinding en opslagbeperking, en je beveiligt met encryptie en toegangsbeheer. Pseudonimisering verlaagt risico’s maar blijft persoonsgegevens; pas bij echte anonimisering valt data buiten de AVG.

Pseudonieme, anonieme en geaggregeerde data

Pseudonieme data maak je door directe identificatoren te vervangen door codes, tokens of gehashte waarden. Je verlaagt het risico, maar het blijft persoonsgegevens onder de AVG, omdat je met een sleutel of combinatie van kenmerken nog kunt terugleiden. Je beheert daarom de verwijzingstabel strikt, gebruikt salts bij hashing en beperkt toegang. Anonieme data kun je redelijkerwijs niet meer naar een persoon herleiden.

Je verwijdert of veralgemeniseert velden, voegt waar nodig ruis toe en checkt of koppeling met externe bronnen geen heridentificatie oplevert. Geaggregeerde data bundel je naar groepen, perioden of regio’s voor analyses en delen met derden. Let op kleine aantallen; pas drempels, k-anonimiteit of afronding toe. Kies de techniek die past bij je doel, documenteer je aanpak en wees eerlijk over rest-risico’s.

First-party, third-party en open data

First-party data verzamel je zelf via je site, app, kassa of klantenservice. Je hebt er de meeste controle over, weet hoe het is verkregen en kunt toestemming, kwaliteit en retentie strak regelen. Third-party data komt van partijen buiten je directe relatie, bijvoorbeeld data brokers of advertentienetwerken; handig voor bereik en verrijking, maar je moet kritisch zijn op herkomst, licenties, toestemming en actualiteit, zeker nu third-party cookies verdwijnen en transparantie belangrijker wordt.

Open data is vrij beschikbaar van overheden en organisaties en is ideaal als referentie of context, mits je licentievoorwaarden respecteert en de bron controleert. Door deze drie soorten bewust te combineren bouw je een betrouwbaar datalandschap, verbeter je analyses en verklein je risico’s rond privacy, compliance en kosten.

[TIP] Tip: Label elk gegevenstype naar herkomst en gevoeligheid; beperk toegang.

Toepassing in de praktijk: kiezen en werken met de juiste soort

Kiezen en werken met de juiste soort gegevens begint bij je doel en vraag. Wil je transacties vastleggen en betrouwbaar rapporteren, dan past gestructureerde data met een duidelijk schema en SQL. Bouw je API’s of verwerk je events met wisselende velden, dan is semi-gestructureerde data handig. Werk je vooral met content zoals teksten, beelden of audio, dan kies je ongestructureerde data met slimme verrijking via tags, extractie en zoektechniek. Check daarna herkomst en gevoeligheid: first-party is meestal het meest betrouwbaar, third-party en open data verrijken, maar vragen extra aandacht voor rechten, licenties en AVG. Kies de tijdsdimensie die past: batch voor periodieke verwerkingen, realtime voor directe feedback, of streaming voor continue datastromen, en stem je opslag daarop af (bijvoorbeeld datawarehouse, documentstore of object storage).

Bewaak kwaliteit met data-validaties, duidelijke definities en monitoring, en leg metadata vast voor herkomst en betekenis. Houd kosten in toom met lifecycle-beleid (hete versus koude opslag), compressie en slimme partitionering. Beveilig met encryptie en toegangsbeheer (rolgebaseerd), en documenteer keuzes zodat teams consistent werken. Door je data bewust te classificeren, maak je snellere keuzes in architectuur en processen, verminder je risico’s en zet je informatie om in resultaten die blijven tellen.

Gebruik en tijdsdimensie: batch, realtime en streaming

Batch betekent dat je data op vaste momenten verwerkt, bijvoorbeeld elk uur of ‘s nachts. Handig als de tijdsdruk laag is en je kosten en complexiteit wilt beperken. Realtime richt zich op directe respons binnen seconden; je gebruikt het voor waarschuwingen, personalisatie of operationele dashboards waar vertraging storend is. Streaming verwerkt een continue stroom records en berekent doorlopend met tijdvensters, zodat je trends en afwijkingen snel ziet zonder te wachten op een batch.

Kies op basis van latentie-eis, datavolume, fouttolerantie en consistentie. Vaak combineer je ze: realtime voor snelle signalen, streaming voor aggregatie en batch voor herberekeningen, archief en gecontroleerde kwaliteitschecks.

Doel van je data: transactioneel VS analytisch; kwalitatief VS kwantitatief

Het doel van je data bepaalt ontwerp en tooling. Transactionele data legt individuele gebeurtenissen vast, zoals orders en betalingen, en vraagt lage latentie, hoge betrouwbaarheid en ACID-transacties in een strak genormaliseerd schema; je optimaliseert voor snelle writes en consistente reads. Analytische data dient voor inzichten, trends en voorspellingen; je transformeert naar een historisch, vaak gedimensioneerd model met aggregaties en denormalisatie voor snelle queries en dashboards.

Kwantitatieve data zijn meetbare cijfers waarmee je telt, vergelijkt en modelleert. Kwalitatieve data omvat beschrijvingen, reviews, interviews en context die je met codering, text mining of AI vertaalt naar thema’s. In de praktijk combineer je ze: transactioneel als bron, analytisch als afnemer, kwantitatief voor statistiek en kwalitatief voor betekenis en verklaring.

Checklist: kwaliteit, compliance en kosten

Begin bij kwaliteit: leg eenduidige definities vast, valideer datatypes, bereiken, unieke sleutels en referenties, meet volledigheid, nauwkeurigheid en actualiteit, en monitor met alerts en data lineage zodat je fouten snel vindt. Voor compliance check je AVG-grondslag, doelbinding en dataminimalisatie, stel bewaartermijnen en verwijderprocessen in, beheer toegang via rollen en least privilege, versleutel in rust en tijdens transport, log verwerkingen en sluit verwerkersovereenkomsten af.

Beoordeel ook risico’s met een DPIA waar nodig. Beheers kosten door storage tiers en lifecycle-beleid te gebruiken (hete, warme en koude opslag), compressie en partitionering toe te passen, onnodige kopieën te schrappen, query’s te optimaliseren en egress en licenties mee te nemen. Documenteer keuzes, eigenaarschap en SLA’s zodat teams consistent en voordelig werken.

Veelgestelde vragen over soorten gegevens

Wat is het belangrijkste om te weten over soorten gegevens?

Soorten gegevens zijn indelingen op structuur, herkomst en gevoeligheid: gestructureerd, semi-gestructureerd, ongestructureerd; first-party, third-party en open; persoonsgegevens en bijzondere persoonsgegevens. Begrippen als data, metadata en datamodellen sturen context, vindbaarheid, governance en toepasbaarheid.

Hoe begin je het beste met soorten gegevens?

Begin met doelbepaling (transactioneel versus analytisch; kwalitatief versus kwantitatief), inventariseer bronnen, classificeer gevoeligheid volgens AVG, leg metadata vast, kies passende opslag/formaten (SQL, CSV, JSON), ontwerp batch of realtime/streaming-processen, borg kwaliteit, compliance en kosten.

Wat zijn veelgemaakte fouten bij soorten gegevens?

Veelvoorkomend: onduidelijke definities, geen datacatalogus of metadata, verkeerde AVG-classificatie (pseudoniem is niet anoniem), alles in één pipeline proppen, schema-evolutie negeren, third-party zonder herkomstcontrole, kwaliteitstests overslaan, kosten en performance onderschatten.